Internet

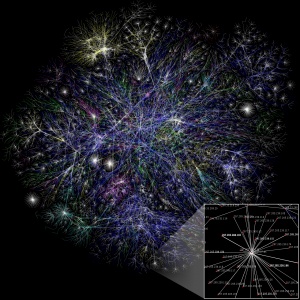

Das Internet (von englisch interconnected network), kurz das Netz, ist ein weltweites Netzwerk bestehend aus vielen Rechnernetzwerken, durch das Daten ausgetauscht werden. Es ermöglicht die Nutzung von Internetdiensten wie E-Mail, Telnet, Usenet, Dateiübertragung, WWW und in letzter Zeit zunehmend auch Telefonie, Radio und Fernsehen. Im Prinzip kann dabei jeder Rechner weltweit mit jedem anderen Rechner verbunden werden. Der Datenaustausch zwischen den einzelnen Internet-Rechnern erfolgt über die technisch normierten Internetprotokolle. Die Technik des Internets wird durch die RFCs der Internet Engineering Task Force (IETF) beschrieben. Umgangssprachlich wird „Internet“ häufig synonym zum World Wide Web verwendet, da dieses einer der meistgenutzten Internetdienste ist und wesentlich zum Wachstum und der Popularität des Mediums beigetragen hat. Im Gegensatz dazu sind andere Mediendienste, wie Telefonie, Fernsehen und Radio erst kürzlich über das Internet erreichbar und haben parallel dazu ihre ursprüngliche Verbreitungstechnik. Das Internet hat durch seine neuartige Technik und Verwendung eine eigene Sprachlichkeit hervorgebracht.

Was ist das Internet?

Das Internet, das sind Tausende von Netzwerken und Millionen von Computern, deren erster Zweck der Austausch von Informationen ist.

Wie bei vielen komplexen Systemen läßt sich auch dieses am besten mit Metaphern erklären. Und die bekannteste und am weitesten verbreitete hier ist „Datenautobahn”. Das Internet läßt sich am besten darstellen als ein Verkehrsverbund mit großen Transportadern wie den Autobahnen und vielen kleinen Zuleitungen wie Bundesstraßen, Eisenbahn-, Bus- und Schiffahrtslinien.

Wobei im Internet die Bedeutung der Autobahnen den sogenannten „Backbones” zufallen. Wörtlich übersetzt bedeutet das Wirbelsäule und wie eine solche übernehmen große Datenleitungen den Hauptanteil des Datenverkehrs.

Dadurch, daß sie miteinander verknüpft sind, entstehen schnellste Linien, die obendrein durch die Unzahl von Kreuzungen und Verbindungen die Möglichkeit der Redundanz bieten. Dies bedeutet, daß beim Ausfalle einer Leitung die Daten auf einem anderen Weg ans Ziel gelangen, mit geringem Zeitverlust oder womöglich Datenverlust.

Diese Backbones werden von großen Internet Service Providers (ISP) betrieben. In den USA sind dies zum Beispiel GTE, MCI, Sprint, UUNet und in Deutschland unter anderem UUNet, Nacamar und Topnet. Die Kosten für den Unterhalt werden sowohl durch Werbung als auch durch die Bereitstellung des Rechnerplatzes für Anbieter und Leitungskapazitäten aufgefangen.

Wie funktioniert das Internet?

Das Geheimnis des Internets ist ein Netzwerk-Protokoll namens TCP/IP, ein Art Kodierung, die es Computern ermöglicht, sich gegenseitig über ein Netzwerk Daten zu beschreiben.

Dieser Ausdruck besteht aus zwei Teilen: Das Transmission Contol Protocol (TCP) und das Internet Protocol (IP). Beide zusammen ergeben eine Art Esperanto des Internets: Jeder Computer, der an das Internet angeschlossen ist, versteht diese Protokolle und gebraucht sie, um Daten an einen anderen Rechner im Internet zu senden und von dort zu empfangen

TCP/IP erzeugt ein sogenanntes packet-switched network, ein Netzwerk, dazu gedacht, einen möglichen Datenverlust beim Transport über die Leitungen so gut wie auszuschließen.

TCP zerlegt jede Art von Daten, seien es e-Mail oder Anweisungen, die ein Java-Applet erteilt, in kleine Teile, die Pakete. Jedes dieser Pakete erhält eine Art elektronischen Umschlag, der die Adressen des Absenders und des Empfängers mit sich führt. Sodann legt das IP fest,auf welchen Wegen diese Pakete auf ihrer Reise von A nach B über verschiedene Router geschickt werden. So passiert z.B. eine e-Mail etliche "Poststellen" auf ihrem Weg.

Jeder Router prüft die Adressen der Pakete und reicht sie dann weiter an den nächsten. Wenn Ihre e-Mail in zehn Teile aufgeteilt worden war, wird jedes dieser Pakete einen anderen Weg bis in Ihren Briefkasten gefunden haben. Doch werden Sie dies nie erfahren, da beim Eintreffen der Pakete TCP wieder aktiv wird und die Pakete identifiziert und auf ihre Unversehrtheit prüft. Wenn alle Pakete ordnungsgemäß eingetroffen sind, setzt TCP sie wieder zum Original zusammen:

TCP/IP ist das wichtigste einer Unzahl von Internet-Protokollen, zu denen unter anderem das Simple Mail Transfer Protocol (SMTP), das File Transfer Protocol (FTP), und das Telnet Protocoll gehören.

Was ist das Web?

Auch wenn die Begriffe Internet und Web nahezu gleichberechtigt gebraucht werden, bezeichnen sie doch zwei verschiedene Dinge:

Das Internet ist der weltweite Verbund von Computern, der dem Datentransport und dem Austausch von Informationen dient.

Das World Wide Web hingegen ist ein Teil des Internets: Eine Sammlung (wohlgemerkt eine unermeßlich große Sammlung) von "verlinkten" Dokumenten, die für diese Verlinkung ein spezifisches Internet-Protokoll namens HTTP verwenden.

Das Web begann im März 1989, als Tim Berners-Lee

vom Europäischen Rat für Kernforschung CERN (eine Forschungorganisation auf dem Gebiet der Hochenergiephysik) dieses Projekt zur Verbesserung der Kommunikation innerhalb der weitverstreuten Organisation vorschlug. Das Web benutzt ein Gerüst aus einzelnen Seiten, die normalerweise zu ”Sites” zusammengeführt werden. Die Seiten sind in HTML geschrieben, diese Hypertext Markup Language erklärt dem Browser, wie er die Seite und ihre Elemente darzustellen hat. Dieser Hypertext ist die eigentliche Errungenschaft des Webs, denn mit diesem ist es möglich, Seiten mit anderen zu verbinden. Mithilfe der Hyperlinks, den Links, die auch Audio-, Video- und Bilddateien miteinbeziehen können. Einfach auf einen Link geklickt – und schon sind Sie auf einer Site auf der anderen Seite der Welt.

Doch trotz seiner Fähigkeit zu Hyperlinks war das Web lange Zeit nur eine wenig bekannte Alternative zum weniger fortschrittlichen Gopher Protokoll. Aber im Februar 1993 entwickelte der beim National Center for Supercomputing Applications beschäftigte Marc Andreessen den ersten grafischen Web-Browser mit Namen Mosaic. (Andreessen war dann Mitbegründer von Netscape Communications im April 1994.) Und der Rest ist, wie man so schön sagt, Geschichte…

Wie funktioniert das Web?

Das Web gründet auf etlichen Regeln, die den Austausch von Text, Bildern, Musik, Video und anderen Multimedia Daten ermöglichen und unter dem Begriff HTTP, also Hypertext Transfer Protocol, zusammengefasst werden. Webseiten können über das Internet ausgetauscht werden, weil sowohl die Browser, die die Seiten lesen und interpretieren, als auch die Webserver, also die Rechner, auf denen die Seiten abgelegt sind, HTTP verstehen.

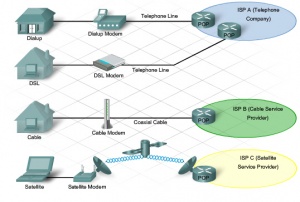

Aber diese könnte nicht weltweit funktionieren, wenn das Web nicht ein Adressierungssystem hätte, daß jeder Rechner im Netzwerk versteht. Dieses basiert auf der IP (Internet Protocol) Adresse, die jeden spezifischen Computer im Netz identifiziert. Sie besteht aus einer vier- bis zwölfstelligen Nummer, die in vier durch Punkte getrennte Blöcke aufgeteilt ist. Jeder Block kann die Zahlen von 0 bis 255 beinhalten. Der ISP, der den Zugang zum Innternet ermöglicht, verteilt jedem Surfer eine eigene Nummer. Diese wird bei jedem Besuch wieder neu generiert, sodaß ein Surfer fast nie zweimal unter derselben IP Adresse im Internet anzutreffen ist. Webserver hingegen haben eine feste IP Adresse, damit sie immer wiedergefunden werden können.

IP Adressen definieren also einen Rechner. Um das Wiederfinden desselben zu erleichtern, gibt es die Domainnamen. So hat zum Beispiel die Agentur Heye & Partner die IP Adresse 195.238.225.152. Um nicht immer zum Besuch dieses Rechners diese Nummer ins Adressenfeld des Browsers eingeben zu müssen unterstützt das Internet eine Name-an-Adresse Übersetzung über den DNS (Domain Name Service), sodaß dieselbe Adresse als Domain lautet: heye.de.(Aber Vorsicht: Alle Plug-Ins vorhanden? Der erforderliche Video-Player für diese Site ist Shareware und kostet ca. 19.95$)

Der Domainnamen identifiziert alle Rechner in einer Gruppe. Doch um auf eine spezielle Seite auf diesem Rechner zu gelangen, bedarf es einer genaueren Adresse. Deshalb hat jede Seite, ja sogar die auf diesen Seiten dargestellten Objekte eine eigene Adresse, die Uniform Resource Locator (URL) genannt wird. Diese "einheitliche Quellen Lokalisierung" erklärt dem Browser genau, wo auf dem angewählten Rechner das gewünscht zu finden ist.

Wer hat mit dem Internet angefangen?

Keiner hat mit dem Internet angefangen.

Die erste "Keimzelle" des Internets kann in einer Reihe von Notizen gesehen werden, die sich J. C. R. Licklide im Massachusetts Institute of Technology 1962 zum Konzept eines "Galaktischen Netzwerkes" machte. Er hatte die Vision eines globalen Netzwerkes, in dem jeder Zugang zu Daten und Programmen haben könnte. Kurz darauf wurde Licklider Leiter des Computer Entwicklungsprogramms beim United States Department of Defense's Advanced Research Projects Agency (ARPA), das die Entwicklung des Internets maßgeblich vorantrieb. Dies allerdings nicht der Mehrung der Kommunikation wegen, sondern einzig und allein aus dem Gedanken heraus, nach einem russischen Erstschlag noch über ausreichende Mengen funktionierender Computer zu verfügen, die dank Dezentralisierung sicherer vor Angriffen waren.

Bereits 1961 machten sich mehrere von einander unabhängige Untersuchungsteams Gedanken über die Entwicklung eines "packet switchings" und somit über die Grundlagen des späteren TCP/IP, des wichtigsten Protokolls für den Informationsaustausch über das Netz. (siehe auch "Wie funktioniert das Internet?").

1967 erschien von Lawrence Roberts, einem weiteren Mitarbeiter der ARPA, der "Plan for the ARPANet", in welchem, basierend auf diesen neuen Technologien, die Architektur eines weltweiten Netzwerkes angedacht wurde.

Gegen Ende 1968 entstanden die ersten Rechner, die in der Lage waren, Daten in das ARPANet zum Versand einzuspielen. (Router). Die Universitäten UCLA und Stanford machten Ende 1969 die ersten Tests.

In den nächsten Jahren wuchs dieses Versuchs-Internet als eine Spielwiese für staatliche Rechenzentren, Universitäten, und Verbände, die alle neue Architekturen und Protokolle entwickelten. E-Mail und das Internet wurden dann 1972 offiziell auf der Internet Computer Communication Conference vorgestellt. 1973 und 1974 trat das Protokoll, das als TCP/IP bekannt wurde, fast schon in seiner heutigen Form in Erscheinung, obwohl seine Entwickler bis in die Anfänge der 80er Jahre an seiner Verbesserung arbeiteten.

Mit dem Erscheinen dieser Protokolle entstanden auch die Software und die Angebote, die das Internet ausmachen. Die grundlegenden Techniken, um Dateien von einem entfernten Rechner zu bearbeiten (via Telnet), Dateien über das Internet zu versenden (via FTP), und elektronische Post zu schicken und zu empfangen, tauchten Mitte bis Ende der 70er Jahre auf. Als Nebenprodukt des Entstehens von Unix entstanden 1979 die Newsgroups im Usenet news system. Das World Wide Web begann 1989

Wer kontrolliert das Internet?

Niemand, keine Person, Firma, Institution, Gesellschaft oder staatliche Organisation besitzt das Internet. Es gibt keine Quelle, die die Rechnung fürs Internet bezahlt. Es gibt keine Regierung und auch keine Kontrolle. Das Internet ist ein Unternehmen für kollektive Zusammenarbeit.

Viele Institutionen und Firmen stellen ihre Rechner und Techniker zur Verfügung um bestimmte Teile des Internets, z.B. schwierige Verbindungen zwischen verschiedenen Regionen, zu warten. Auch sind einige Regierungen bestrebt, auf dem legislativen Weg ihre Autorität geltend zu machen.

Und selbstverständlich muß jeder Computer im Internet ein Grundwissen an Technologie aufweisen, mit deren Wartung, Aktualisierung und allgemeinen Verfügbarkeit etliche Organisationen beschäftigt sind.

Es gibt eine Handvoll dieser Organisationen, die sich einflußreich um das Funktionieren und die Integrität des Internets bemühen:

- Das World Wide Web Consortium (W3C) definiert die Standards für HTML und andere Spezifikationen des Webs.

- Die Internet Engineering Task Force (IETF) konzentriert sich auf die Weiterentwicklung des Internets, damit es flüssig und schnell arbeitet.

- Die Internet Engineering Steering Group (IESG) organisiert die Aktivitäten der IETF und die Entwicklung der Internet Standards.

- Das Internet Architecture Board (IAB) ist für die Gesamtarchitektur des Internets zuständig und steckt somit den Arbeitsrahmen für die IETF ab.

- Die Internet Society (ISOC) ist eine übergeordnete Organisation, die sich aus Personen, Gesellschaften, gemeinnützigen Organisationen und Regierungsstellen aus der Internet Gemeinschaft zusammensetzt. Diese Gruppe kommentiert Internet Verfahrensweisen und Praktiken.

- Die Internet Assigned Numbers Authority (IANA) und das Internet Network Information Center (InterNIC) beaufsichtigen die Institutionen, die mit der Vergabe der IP Adressen und Domainnamen betraut sind (in Deutschland die DeNic).

Telefongesellschaften, Backbone ISPs, Kabel- und Satellitenbetreiber und einzelne Regierungen sorgen für die Telekommunikations-Infrastruktur. Einige dieser Firmen, wie UUNet, BBN, Sprint und MCI, verdienen mittlerweile sehr viel Geld damit, anderen Firmen Zugang zum Internet zu beschaffen.

Doch die totale Kontrolle über das Net wird wohl keiner an sich reißen können, denn dieses ist nicht allein ein Kommunikationsmedium, sondern eine Metapher für die neue Globale Gemeinschaft.

Onlinedienste?

Auf den ersten Blick scheint es nicht mehr viele Unterschiede zwischen Onlinediensten und dem Web zu geben. Doch die Unterschiede, die es gibt, sind einer näheren Betrachtung wert.

Die Verbraucher hatten sich daran gewöhnt, den vier großen Onlinediensten – America Online (AOL), CompuServe, Prodigy, und dem Microsoft Network (MSN) – dafür Geld zu geben, Zugang zu einem weltweiten Netzwerk digitaler Bibliotheken zu haben, e-Mail zu versenden und Online-Gemeinschaften anzugehören, in denen sie ihre Interessen vertraten.

Die Anbieter wiederum erstellten dafür große Netzwerke, die nur von ihren Kunden genutzt werden konnten und alle unterschiedliche System hatten.

Aber dann wurde das Web bekannt, das ein riesiges Netzwerk mit einem System, das des Browsers, allen anbot. Plötzlich sahen sich die großen Anbieter Hunderten von Anbietern, den ISPs, Providern, gegenüber, die alle das anboten, für das die großen Vier viel Geld hatten wollen.

Also passten sich die Onlinedienste an, gewährten ebenfalls Zugang zum Net und verlangten nicht mehr stündliche Gebühren im Voraus für die Nutzung. So sind aus den Onlinediensten große ISPs geworden, von denen sich beispielsweise Prodigy bescheiden "Super-ISP" nennt.

Von diesen betreibt nur noch AOL ein eigenes Netzwerk. MSN, Prodigy und CompuServe haben riesige Web-Sites erstellt und halten darauf ihre Angebote feil (die sie sich nach wie vor bezahlen lassen). CompuServe (das mittlerweile von AOL aufgekauft wurde) und Prodigy nutzen die von ihnen kontrollierten Verbindungen für sogenannte "Premium"-Internetdienste und garantieren (für gutes Geld) große und stabile Übertragungsraten.

Das Interesse an privaten Netzwerken ist immer noch vorhanden. So hat Disney einen Onlinedienst, der gezielt Kinder und Familien anspricht. Auch andere Firmen möchten ihr Webangebot nicht mehr nur über Werbung finanzieren. (siehe auch Was bedeutet "Push-Technologie"?)

Warum ist das Internet so langsam?

Wie kommte es, daß man in der einen Minute nur so durchs Web "fliegt" und in der nächsten der Browser ständig nörgelt: „waiting for reply” oder „transmitting data”?

Zum Teil ist es ein Fehler des Internets. Damit es eine große Bandbreite unterschiedlicher Daten transportieren kann, muß es Zugeständnisse an die Übertragungsgeschwindigkeit machen. Jede e-Mail oder jeder Download beansprucht das Netz ebenso wie Webseiten, die obendrein Grafik und Multimediadaten mit sich schleppen.

Im Web kann (streng nach Murphy's Gesetzen) praktisch alles schiefgehen: das eigene Telefonkabel kann beschädigt sein; der anbietende (Host) Rechner kann wegen Überlastung oder Wartung abgeschaltet worden sein; ein Backbone kann wegen zuvieler Anfragen zusammengebrochen sein. Und genauso gut ist es wenige Mintuen später wieder so, als wäre nichts gewesen.

Auf jeden Fall hilft das Wissen um die Fehlermöglichkeiten, ein wenig gelassener mit dem Web umzugehen. Hier also die gebräuchlichsten Fehlermeldungen:

Allgemeine Server Fehlermeldungen

404

Der anbietende (Host) Rechner hat dem Brwoser geantwortet, kann aber die gewünschte URL nicht liefern. Das kann bedeuten, daß das gewünschte Dokument auf diesem Rechner verschoben oder gar vernichtet wurde. Es kann aber auch bedeuten, daß die angeklickte oder eingegebene Adresse nicht stimmt. So kann der Rechner beispielsweise das Dokument "tralala.htm" nicht finden, wenn er nach "tralala.html" gefragt wurde.

403

Die angefragte Datei ist zugriffsgeschützt und ohne den richtigen Benutzernamen und das richtige Passwort nicht zu erreichen.

503

Der Server ist einfach überlastet und kann die Anfrage nicht beantworten. Am besten nach ein paar Minuten noch einmal versuchen.

Allgemeine Browser Fehlermeldungen

Unable to locate server

Der Browser konnte keinen Server des angegebenen Namens finden. Offensichtlich ist die Serveradresse falsch.

Host unavailable

Der genaue Wortlaut variiert von Browser zu Browser, es bedeutet aber immer, daß die gesuchte Domain existiert, nicht aber auf die Anfrage reagiert. Normalerweise taucht dieses Problem auf, wenn der Server so ausgelastet ist, daß er praktisch "offline" ist, wenn er wartungshalber heruntergefahren (abgeschaltet) wurde oder aus sonst einem Grund nicht erreichbar ist. Da hilft nur Warten und es ein paar Minuten später noch einmal zu versuchen.

Wie sicher ist das Internet?

Das Internet ist so sicher wie eine dunkle Gasse. In dieser können sich finstere Gestalten herumtreiben, sie können es aber auch nicht. Dennoch ist man nicht hilf- und schutzlos.

Diese finsteren Gestalten, so es sie gibt, stellen in zwei Richtungen Bedrohungen dar: in Angriffen auf die Sicherheit und in Angriffen auf die Privatsphäre.

Sicherheitsrisiken beinhalten Dateien-Downloads, die Viren transportieren können, ActiveX-Elemente, die einen Computerabsturz verursachen können, zweifelhafte e-Mail Anhänge (attachments), Lücken in Java, die einem Hacker ermöglichen können, Daten auf fremde Festplatten zu spielen und natürlich eine Menge Schwächen in der unübersehbar gewordenen Internet-Software.

Allen Gerüchten zum Trotz ist es eher unwahrscheinlich das Opfer eines Hackers zu werden. Die Wahrscheinlichkeit eines Virus ist ungleich höher, doch dagegen gibt es wirksame Anti-Viren-Programme. Wie im richtigen Leben, darf man auch im Internet nicht zu leichtsinnig sein: E-Mail Anhänge (Attachments) von Unbekannten sollten nicht ohne weiteres geöffnet werden. Die eigene e-Mail Adresse (und erst recht die Postanschrift) sollte nur dort preisgegeben werden, wo man weiß, mit wem man es zu tun hat und was man zu erwarten hat. Das gleiche gilt natürliche auch für Kreditkarten-Transaktionen.

Die Angriffe auf die Privatsphäre sind subtiler; doch auch hier gibt es Schutz. Die eigene e-Mail Adresse kann zum Beispiel durch ein Verschlüsselungsprogramm (wie PGP – pretty good privacy des renommierten Massachusetts Institue for Technology, MIT)vor dem Ausspähen gesichert werden.

Doch das Hauptinteresse richtet sich eher auf die Erforschung des Surf- und Kaufverhalten denn auf das Lesen fremder e-Mail. Kundenprofile werden so anhand des Surfverhaltens erstellt und sind bestimmte Agenturen erst einmal im Besitz einer e-Mail Adresse, ist der Inhaber derselben mindesten unglücklicher Empfänger zahlloser Werbemails.

Viele Webseiten sind speziell der Erforschung des vorbeikommenden Surfers geschuldet. Sie senden z.B. kleine Dateien, sogenannte Cookies, auf die Festplatte des besuchenden Rechners. Jeder Cookie kann nur von dem Rechner gelesen werden, der ihn generiert, und das Tage, Wochen oder Monate nach dem Besuch. Unter anderem können Cookies den Benutzernamen, dessen e-Mail Adresse, dessen ISP-Namen, die zuletzt besuchte Seite, dessen Betriebssystem, Browser-Typ und -Version erfragen. Sie können auch dem Surfer helfen, indem sie sich ein einmal eingegebenes Passwort (für passwortgeschützte Seiten) merken und so das wiederholte Eingeben bei den folgenden Seiten ersparen.

Aber der aufgeklärte Kunde hat das Recht auf Kontrolle über die Informationen, die über ihn gesammelt werden. Zum einen bietet der Browser in den Voreinstellungen (Preferences, Einstellungen) die Möglichkeit, Cookies prinzipiell abzulehnen oder zumindest, was empfehlenswert ist, diese nur nach Bestätigung zuzulassen. Zum anderen gibt es Programme wie Kookaburra Software's CookiePal, die Cookies kontrollierbar machen können.

Übrigens werden auch Newsgroups schon mal von finsteren Gesellen nach e-Mail Adresse durchforstet. Bei der Beteiligung an einer Newsgroup wird in den meisten Fällen auch die e-Mail Adresse des Teilnehmers bekanntgegeben. Es gibt u.a. anonyme "Remailer-Services", wie z.B. Replay, der Ihre e-Mail ohne Ihre e-Mail Adresse weiterleitet (Forwarded).

Was ist eine Suchmaschine?

Wenn die Frage nach dem Thesaurus Indogermanischer Text- und Sprachmaterialien auftaucht (und taucht sie nicht jeden Tag aufs neue auf?), gibt’s doch nichts klügeres als das Web. Aber da ist das Suchen – und da ist das Finden.

Und damit beides erfolgreicher verläuft, hier einige technische Aspekte der Suche im Internet.

Das Web bietet drei verschiedene Grundtypen an: Suchmaschinen, Webverzeichnisse und Metasearch Sites.

Suchmaschinen, wie z.B. Excite und HotBot benutzen eine automatisierte Software, die Webcrawler (Netzkrabbler) oder Spider (Spinne) genannt werden. Sie "krabbeln" von Website zu Website, registrieren jeden Seitentitel, jede URL, und ein wenig des Textzusammenhanges. Es geht darum, Millionen von Webseiten zu treffen (Hits) und somit so aktuell wie möglich zu sein.Heraus kommt eine große Datenbank mit Webseiten, die der Benutzer mit der Eingabe eines Suchbegriffs oder einer Phrase abfragen kann.

Webverzeichnisse wie Yahoo und Magellan bieten eine redaktionell betreute und nach Begriffen sortierte Liste von Webseiten an.Obendrein arbeiten Redakteure am Finden neuer Seiten und Programmierer an deren Katalogisierung und Verlinkung (Link) zum Verzeichnis.

Da beide Herangehensweisen Sinn machen, bieten mittlerweile die Suchmaschinen Kategorien an und die Webverzeichnisse Schlüsselwortsuchen.

Parallel- und Metasearch Sites starten auf allen populären Suchmaschinen eine gleichzeitige Suche und präsentieren die Ergebnisse in einem Fenster.

Obendrein erleichtern Metasearch-Maschinen die Suche, da sie dem Suchenden das Syntax-Problem abnehmen. So müßte beispielsweise eine Suche nach dem Thesaurus Indogermanischer Text- und Sprachmaterialien in der Suchanfrage genauso formuliert werden. Bei Infoseek wäre es besser, +Thesaurus+Indogermanischer+Text+Sprachmaterialien als Suchbegriff einzugeben und bei Galaxy hieß es ThesaurusANDIndogermanischerANDTextANDSprachmaterialien. Metasearch Sites wie Metasearch.com, benutzen automatisch bei jeder Suchmaschine die passende Syntax.

Was sind Java und ActiveX?

Die Version der Seitenbeschreibungssprache HTML, die von den meisten eingesetzten Browsern verstanden wird, liefert nur recht statische Webseiten. Damit diese aber beweglich, interaktiv seien, entstanden Java und Microsoft’s ActiveX.

Die Firma Sun entwickelte mit Java eine dem C++ verwandte Programmiersprache. Java Anwendungen, im Web bekannt als Applet, laufen unter jedem Betriebssystem, sei es Macintosh, Windows oder Unix, da sie durch den Browser übersetzt werden.

Diese Applets sind zuhauf im Internet als Shareware oder als Freeware zum Download auffindbar. Dessen ungeachtet ist Java nicht einfach mal so nebenbei geschrieben. (Anm.: JavaScript, oder JScript, ist nicht Java. JavaScript ist eine Script-Sprache, die, da sie ohne Kompilierung und Interpretierung [Übersetzung] auskommt, leichter zu schreiben ist.)

ActiveX Controls sind dahingehend vergleichbar mit Java Applets, daß sie in Webbrowsern laufen und daß sie Webseiten bereichern helfen. Aber wo Java eine ausgewachsene Programmsprache ist, ist zu bemerken, daß ActiveX Microsofts Visual Basic Umfeld entspringt. Es ist also eng mit anderen Microsoft Technologien verknüpft – so lassen sich mit ActiveX aus dem Browser heraus Excel oder Word Dokumente betrachten. Anders als Java ist ActiveX jedoch in erster Linie für Windows konzipiert und lief lange Zeit auch nur unter Microsofts Internet Explorer.

Es bliebe noch anzumerken, daß sich in ActiveX leichter etwas verstecken läßt, das auf der Anwenderplatte ungeahnte Dinge (und auch Schäden) hervorrufen kann. (Java läuft in einer eigenen Umgebung, der sog. console, ActiveX auf der Betriebssystemebene).

Was ist ein Intranet?

„Digitale Sackgassen, die ins Internet verbunden sind, aber Dritten keinen Zugriff gestatten.”, so beschreibt eine bekannte Publikation die Intranets. In der Tat sind diese Intranets kleine, abgeschlossene Internets im Internet, also autarke, nicht öffentliche Netzwerke.

Im Intranet ist eine Navigation wie im Web möglich, mit Browsern, über Webserver und Websites. Diese Technik ist für viele Firmen die günstigste und einfachste Möglichkeit des Ideen- und Datenaustausches, da kaum zusätzliche Kosten für Rechner oder allseits kompatible Software entstehen. Intranets sind durch Firewalls vom Internet abgeschottet, die den Angehörigen der Firma das Surfen im Web ermöglichen, aber jeden Zugriff von außen verwehren. (Anm.: Mittlerweile werden unter dem Schlagwort "Extranet" Überlegungen angestellt, mehrere Intranets so miteinander zu verknüpfen, daß mehrere Firmen über ihre eigenen Intranets mit anderen Firmen über deren Intranets kommunizieren und so zusammenarbeiten könnten.)

Wie funktioniert e-Mail?

E-Mail unterscheidet sich eigentlich kaum von normaler Post; es gibt eine Botschaft, eine Adresse und einen Überbringer, der die Botschaft von A nach B bringt.

Nur wird eine e-Mail und jeder mögliche Anhang (Attachment) in viele kleine Pakete aufgesplittert und auf unterschiedlichen Wegen zum Empfänger transportiert, wo sie wieder zusammengesetzt wird. (siehe auch TCP/IP).

Die e-Mail wird über zwei TCP/IP Protokolle verarbeitet: das POP3, das SMTP und IMAP4.

Das Post Office Protocol3 ist ein Protokoll für Server im Internet, die e-Mail empfangen, speichern und übertragen. Dieses Protokoll wird auch beim Client von Computern eingesetzt, die eine Verbindung zum Server aufbauen um eine e-Mail zu laden, bzw. herunterzuladen.

Simple Mail Transfer Protocol ist ein TCP/IP Protokoll für die Übertragung von Nachrichten zwischen einzelnen Computersystemen über ein Netzwerk. Im Internet wird es für die Weiterleitung von e-Mail verwandt.

Beide Protokolle zusammen ermöglichen dem Benutzer, seinen "Briefkasten" bei seinem ISP zu verwalten. Also die Dateien, die auf dem Rechner seines ISP auf den für ihn reservierten Teil der Festplatte geschrieben wurden. Denn dieser "Briefkasten" ist der durch den Vertrag mit dem ISP definierte Speicherplatz, über den der Benutzer im gewissen Rahmen verfügen darf.

Eine e-Mail setzt sich im "lesbaren" Teil aus der Adresse, dem "Betrifft" ("Subject"), der eigentlichen Mail, dem Absender und möglichen Anhängen zusammen. Diese Anhänge können aus beigefügten Dateien (den sog. Attachments) bestehen, aber auch ein "Signature-File" beinhalten. Diese "Unterschrifts-Datei" läßt sich in nahezu jedem e-Mail-client (also dem e-Mail Programm) erzeugen und hängt an jede e-Mail eine Art Visitenkarte des Absenders an. Ebenso bietet sich die Möglichkeit, der e-Mail einen "elektronischen Daumenabdruck" beizufügen. Diese, u.a. von der Firma VeriSign angebotene, Verfizierungsmethode kennzeichnet jede e-Mail unverwechselbar, sodaß der Empfänger immer sicher sein kann, daß der angegebene Absender auch der tatsächliche Absender ist. (Manche e-Mail-Clients bieten unter dem Stichwort Sicherheit die Möglichkeit, die Verfizierung zu generieren.)

Was sind Newsgroups?

Nun hat unser Freund aus Frage 10 über Suchmaschinen schon einiges über den Thesaurus Indogermanischer Text- und Sprachmaterialien herausgefunden. Jetzt will aber sein Schwager mit ihm nur über Autos reden. Mit wem kann er sich austauschen?

Eine Möglichkeit bieten die sogenannten Newsgroups.

Newsgroups sind öffentliche Diskussionsforen im Internet. Diskussionsbeiträge werden in Listen, den sog. threads, dargeboten, die die Beiträge (inkl. e-Mail Adresse), die Antworten darauf, die Antworten auf die Antworten, die Antworten auf die Antworten der Antworten auf den Beitrag, usw., auflisten, sodaß die gesamte "Diskussion" am Stück oder in Scheiben verfolgt werden kann.

Newsgroups entstammen dem Usenet, das schon vor dem Web weltweit zahllose Unix-Rechner zum Informationsaustausch verband. Deshalb verstehen nicht alle Browser die Technologie per se. Netscape (mit Collabra) und Internet Explorer ( mit Outlook Express) bieten aber Kombinationen, die einen Zugang ermöglichen. Ansonsten gibt es Programme wie z.B. den Free Agent von Forté.

Diese Newsreader ermöglichen eine Navigation wie ein Browser. Um sich im Usenet zurechtzufinden, sind die Newsgroups in Kategorien zusammengefasst. Diese verzweigen sich wie auf einer Festplatte immer weiter, sodaß schließlich Adressen wie diese herauskommen: microsoft.public.inetexplorer.ie.setup (hier geht’s nur um die Installation des Internet Explorers ).

Was bedeutet „Push”-Technologie?

Manch einer meint, das Internet wäre mit zuviel Arbeit verbunden. Mühsam muß man suchen und gerade das Interessanteste ist so versteckt…

So entstand die "Push"-Technologie. Die gewünschten Informationen werden auf den eigenen Rechner geliefert, "gepusht", und müssen nur noch gelesen werden.

Um "push" (drücken, stoßen) zu verstehen, muß erst einmal "pull" (ziehen, holen) geklärt sein.

Das Web basiert auf dem Modell des "pulled content", was bedeutet, daß der Browser einen Webserver anspricht und sich von diesem das gewünschte auf die eigene Platte "zieht".

Also liefert Pushechnologie durch selbständiges "Drücken" die Informationen frei Haus. Dem Fernsehen vergleichbar sprechen die Anbieter auch von "Kanälen ("channels"), in die sich der Browser "einschaltet" ("tune in to"). Nach Sparten getrennt, finden sich Kanäle für Sport, Nachrichten, Börse, usw.

Einige Anbieter bieten "smart pull" an, bei dem beispielsweise aktuelle Schlagzeilen auf den Rechner gepusht werden. Um jedoch die ganze Nachricht zu lesen, muß die Schlagzeile angeklickt werden, was wiederum auf die Website führt.

Genausogut lassen sich über Kanäle Programme auf dem neuesten Stand halten.Marimba z.B. bietet Pushtechnologie an, die in Intranets automatisch die verwandte Software aktualisiert.

Das Hauptproblem der Pushtechnologie ist, neben der Frage der Bevormundung des Surfers, die Leitungsbelegung. Gerade in großen Intranets können leicht Engpässe auftreten, wenn viele Endplätze mehrmals täglich Nachrichten zugespielt bekommen.

Wie mache ich eine Webseite?

Wie bei aller Arbeit, ist auch für das Erstellen von Webseiten ein wenig grundlegendes Wissen nicht hinderlich.

Eine Webseite ist eine "Hyper-Text"-Seite, d.h., sie ist "aktiv": Links ermöglichen z.B. das Springen von einer Seite zur anderen.

Damit ein Text "aktiv" wird, muß er in einer bestimmten Sprache geschrieben worden sein, nämlich in HTML. Diese Hypertext Markup Language benutzt einfache Befehle und Formulierungen, die Tags, die vom Browser dahingehend interpretiert werden, bestimmte Aktionen auszuführen. Diese Aktionen sind aber nur auf die Oberfläche des Browsers beschränkt und greifen nicht auf das System des Rechners zu. Die Tags beschreiben die Formatierung der verwandten Schrift, die Einbindung von Bildern und deren Plazierung und vieles mehr.

Eine Webseite läßt sich im Quellcode (source) schreiben oder unter Zuhilfenahme eines WYSIWYG-Editors, je nach persönlichem Geschmack. (Der verbreitetste Source-Editor ist BBEDIT, der entsprechende WYSIWYG-Editor Microsoft’s FrontPage 98).

Eine fertige Webseite sollte auch im Web erscheinen. Viele große Provider haben sehr günstige Kurse für den Webserver Speicherplatz; doch weisen diese Angebote zwei entscheidende Nachteile auf: Zum einen erhält die Seite oder die Site eine komplizierte URL, sie verschwindet in einem Adressfeld wie z.B. http://www.tiac.net/users/sfinnie/index.html. Zum anderen können solche Angebote kaum mit ausführlicher und intensiver individueller Beratung, Betreuung und Hilfe kalkuliert worden sein.

Die Adressierung der eigenen Website kann natürlich auch auf einer "top-level-domain" erfolgen. Dies sind Adressen, die sich nur aus "www" (für world-wide-web – als Erklärung für den Browser, in welchem Teil des Internets er suchen soll), dem eigenen Namen und der Länderkennung (also z.B. de für Deutschland – als Erklärung für den Browser, in welchem Land er suchen soll) zusammensetzen. Die top-level-domains werden in Deutschland von der DeNic verwaltet. Gegen Gebühren garantiert sie die Einmaligkeit der Domainnamen.

Vom Chatten und Schwätzen

Wer behauptet, Computer machen einsam, hat bestimmt noch nie einen Chatroom aufgesucht.

Diese Chat-Räume (chat = plaudern, schwatzen) finden sich immer vermehrter auf allen möglichen Websites. Sie sind meistens als Echtzeit-Foren zu einem bestimmten Thema gedacht.

Der "Raum" besteht natürlich nur aus einer Webseite, auf der in ein Texteingabefeld geschrieben werden kann. Dieser Eintrag kann von allen, die gleichzeitig in diesem "Raum" sind, gelesen und beantwortet werden. Die "Räume" werden vom Anbieter des Chats definiert, genausogut lassen sich mit einem oder mehreren Teilnehmern in einem "Raum" eigene private Räume definieren, die dann einen Chat quasi "unter vier Augen" ermöglichen.

Sehr viele dieser Chatrooms werden vom IRC, dem Internet Relay Chat, organisiert. Für die Teilnahme daran wird der Chat-Client mIRC benötigt, der aber einige Sicherheitslücken aufweist und mit Vorsicht zu genießen ist.

Grundsätzlich mag es ja Chatrooms geben, die einen vernünftigen Gedankenaustausch zu relevanten Themen bieten, doch ist die Mehrzahl der Chatrooms doch mit unvernünftigem Geschwätz angefüllt.

Was gibt’s sonst noch im Web?

Der heutige Internetbenutzer surft ein bißchen, verschickt e-Mails, nimmt an einer Newsgroup teil und chattet dann und wann. Doch daneben existieren im Internet die Ahnen der heutigen Internetanwendungen, die immer noch frisch und aktiv sind.

Alles begann mit dem file transfer protocol (FTP), mit dem Dateien über das Netz verschickt werden können. Internet Dateien, zumeist auch Software zum Download liegen auf FTP-Servern. Um diese Dateien verwalten zu können, ist ein FTP-Client nötig (z.B. Ipswitch's WS_FTP).

Archie ist ein Suchwerkzeug um in FTP-Archiven bestimmte Dateien finden zu können. (Archie klingt so ähnlich wie Archiv; klar?)

Telnet ermöglicht den administrativen Zugriff auf die Unix-Rechner, die den Großteil der Internet-Rechner (Server) stellen.

Gopher ermöglicht das Finden und Bewegen von FTP- und Telnet-Dateien über das Netz. Vor dem Web war Gopher das Werkzeug um sich im Internet zurechtzufinden. Die University of Minnesota, an der Gopher entwickelt wurde (Gopher hieß das Universitäts Maskottchen und ist auch ein Verballhornung von "go for") ermöglicht in ihrem University of Minnesota Gopher Archiv interessante Einblicke in die Geschichte des Internets.

Wird das Web das neue TV?

Mahnende Stimmen sehen im Web das Ende des TV. Warum soll man sich ständig mit irgendwelchen Wiederholungen rumärgern, wenn man doch beim Surfen alles finden kann. Dennoch werden sich die beiden Technologien immer ähnlicher.

Die Verschmelzung der beiden böte sich auf vielen Gebieten an. Während der Übertragung eines Eishockeyspiels könnte man beispielsweise einen Spieler anklicken, um so Informationen über seine Schußstatistik oder seine Vorlieben abzurufen.

Der eine Weg wird von Firmen wie WebTV (mittlerweile von Microsoft aufgekauft) beschritten, die mittels Set-Top-Boxen das Web auf den Fernseher bringen. Bestrebungen gehen dahin, die Webdaten in die Fernsehsignal einzubetten(Stichwort: Intels Intercast).

Streaming Multimedia ist das andere Zauberwort. Statt das komplette Herunterladen einer Multimediadatei abzuwarten, werden die Informationen "fließend" aufbereitet. Während also der Film noch geladen wird, kann man ihn sich schon ansehen. Die Webradiosender, wie CNET Radio arbeiten mit RealAudio von ProgressiveNetwork, für bewegte Bilder empfiehlt sich RealVideo und VXtreme’s Web Theater (mittlerweile von Microsoft aufgekauft).

Natürlich begegnen einem hier wieder die Hauptprobleme des Webs, die Übertragungsrate und die Bandbreite. Beide liefern noch nicht die Werte um Fernsehen im Web wirklich attraktiv zu machen. ISDN ist ein erster Schritt in die Richtung, doch müssen auch die physikalischen Datenträger, also die Leitungen, größeren Leistungen gewachsen sein. Wenn die Übertragung nicht über Satellit erfolgen wird, sind mindestens Glasfaserverkabelungen von Nöten, den Anforderungen der Übertragungsprotokolle der kommenden Generationen gewachsen zu sein.